Accueil > 01 - PHILOSOPHIE - PHILOSOPHY > Chapter 07 : Dynamical contradictions - Des contradictions dynamiques > L’auto-organisation ou l’ordre spontanément issu du désordre

L’auto-organisation ou l’ordre spontanément issu du désordre

vendredi 23 novembre 2012, par

Les philosophes et les scientifiques ont longtemps cherché un ordre au-delà de l’apparent désordre. Du coup, ils ont isolé des éléments ordonnés comme l’atome, la cellule, d’ADN, l’Etat et ont cherché à en faire le principe de base fondamental. Aujourd’hui, une image nouvelle apparaît dans tous les domaines. Il ne s’agit plus d’un ordre sous-jacent mais d’un désordre d’un type particulier. Il n’est pas indéterministe et il est capable de produire à une certaine échelle un ordre.

"On a montré, in vitro, que des neurones isolés de calamar géant ou des petits réseaux isolés de cochon d’inde ou de certains crustacés présentent une dynamique chaotique. (...) Henri Korn et Philippe Faure ont confirmé l’existence (du chaos déterministe) en étudiant l’activité synaptique de neurones de poissons. (...) Même si l’activité des neurones isolés est chaotique, la dynamique du champ moyen peut être régulière : le chaos au niveau neuronal n’implique pas le chaos à grande échelle. Ainsi, le comportement dynamique du cerveau résulte d’une dynamique interne riche, complexe et à plusieurs échelles."

Hughes Berry et Bruno Cessac

dans "Du chaos dans les neurones"

Métamorphoses constructives et destructives de la neige

Radiographie enregistrée lors de la croissance de dendrites colonnaires.(alliage : Al – 3,5 % pds Ni ; G = 7 K/cm ; V = 40 µm/s) Expérience réalisée à l’ESRF (European Synchrotron Radiation Facility) Grenoble.

La croissance dendritique

Structures dissipatives loin de l’équilibre

« Loin de l’équilibre, les processus irréversibles sont source de cohérence. L’apparition de cette activité cohérente de la matière – des « structures dissipatives » - nous impose un nouveau regard, une nouvelle manière de nous situer par rapport au système que nous définissons et manipulons. Alors qu’à l’équilibre et près de l’équilibre, le comportement du système est, pour des temps suffisamment longs, entièrement déterminé par les conditions aux limites, nous devrons désormais lui reconnaître une certaine autonomie qui permet de parler des structures loin de l’équilibre comme de phénomènes d’ « auto-organisation ». (…)

Un système physico-chimique peut donc devenir sensible, loin de l’équilibre, à des facteurs négligeables près de l’équilibre. (…) La notion de « sensibilité » lie ce que les physiciens avaient l’habitude de séparer : la définition du système et son activité. (…) C’est l’activité intrinsèque du système qui détermine comment nous devons décrire son rapport à l’environnement, qui engendre donc le type d’intelligibilité qui sera pertinente pour comprendre ses histoires possibles. (…) On retrouve la notion de sensibilité associée à celle d’instabilité, puisqu’il s’agit, dans ce cas, de la sensibilité du système à lui-même, aux fluctuations de sa propre activité. (…) Nous pouvons décrire un système à l’équilibre à partir des seules valeurs moyennes des grandeurs qui le caractérisent, parce que l’état d’équilibre est stable par rapport aux incessantes fluctuations qui perturbent ces valeurs, parce que ces fluctuations sont vouées à la régression. (…) Le fait que tel ou tel événement puisse « prendre sens », cesser d’être un simple bruit dans le tumulte insensé de l’activité microscopique, introduit en physique cet élément narratif dont nous avons dit qu’il était indispensable à une véritable conception de l’évolution. (…) ces questions ne renvoient ne renvoient pas à une ignorance contingente et surmontable, mais définissent la singularité des points de bifurcation. En ces points, le comportement du système devient instable et peut évoluer vers plusieurs régimes de fonctionnement stables. En de tels points, une « meilleure connaissance » ne nous permettrait pas de déduire ce qui arrivera, de substituer la certitude aux probabilités. (…) La physique des phénomènes loin de l’équilibre a démontré le rôle constructif des phénomènes irréversibles. Nous pouvons désormais affirmer que le message de l’entropie n’a pas pour objet les limites de nos connaissances, ou des impératifs pratiques. (…) Il définit les contraintes intrinsèques à partir desquelles se renouvellent le sens et la portée des questions que ce monde nous autorise à poser. (…)

Nous avons surtout souligné les dimensions négatives du chaos dynamique, la nécessité qu’il implique d’abandonner les notions de trajectoire et de déterminisme. Mais l’étude des systèmes chaotiques est également une ouverture ; elle crée la nécessité de construire de nouveaux concepts, de nouveaux langages théoriques. Le langage classique de la dynamique implique les notions de points et de trajectoires, et, jusqu’à présent, nous-mêmes y avons eu recours alors même que nous montrions l’idéalisation – dans ce cas illégitime – dont elles procèdent. Le problème est maintenant de transformer ce langage, de sorte qu’il intègre de manière rigoureuse et cohérente les contraintes que nous venons de reconnaître.

Il ne suffit pas, en effet, d’exprimer le caractère fini de la définition d’un système dynamique en décrivant l’état initial de ce système par une région de l’espace des phases, et non par un point. Car une telle région, soumise à l’évolution que définit la dynamique classique, aura beau se fragmenter au cours du temps, elle conservera son volume dans l’espace des phases. C’est ce qu’exprime un théorème général de la dynamique, le théorème de Liouville. Toutes les tentatives de construire une fonction entropie, décrivant l’évolution d’un ensemble de trajectoires dans l’espace des phases, se sont heurtées au théorème de Liouville, au fait que l’évolution d’un tel ensemble ne peut être décrite par une fonction qui croîtrait au cours du temps.

Or, un argument simple permet de montrer l’incompatibilité, dans le cas d’un système chaotique, entre le théorème de Liouville et la contrainte selon laquelle toute description définit le « pouvoir de résolution » de nos descriptions ; il existera toujours une distance r telle que nous ne pourrons faire de différence entre des points plus proches l’un de l’autre (…) La nouvelle description des systèmes dynamiques chaotiques substitue au point un ensemble correspondant à un fragment de fibre contractante. Il s’agit d’une description non locale, qui tient compte de la contrainte d’indiscernabilité que nous avons définie. Mais cette description n’est pas relative à notre ignorance. Elle donne un sens intrinsèque au caractère fini de nos descriptions : dans le cas où le système n’est pas chaotique, où l’exposant de Lyapounov est de valeur nulle, nous retrouvons la représentation classique, ponctuelle, et les limites mises à la précision de nos mesures n’affectent plus la représentation du système dynamique.

Cette nouvelle représentation brise également la symétrie temporelle. (…) Là où une seule équation d’évolution permettait de calculer l’évolution vers le passé ou vers le futur de points eux-mêmes indifférents à cette distinction, nous avons maintenant deux équations d’évolution différentes. L’une décrirait l’évolution d’un système vers un équilibre situé dans le futur, l’autre décrirait l’évolution d’un système vers un équilibre situé dans le passé.

L’un des grands problèmes de l’interprétation probabiliste de l’évolution vers l’équilibre était que la représentation probabiliste ne donne pas sens à la distinction entre passé et futur. (…) La nouvelle description dynamique que nous avons construite incorpore, en revanche, la flèche du temps (…) Les comportements dynamiques chaotiques permettent de construire ce pont, que Boltzmann n’avait pu créer, entre la dynamique et le monde des processus irréversibles. La nouvelle représentation de l’objet dynamique, non locale et à symétrie temporelle brisée, n’est pas une description approximative, plus pauvre que la représentation classique. Elle définit au contraire cette représentation classique comme relative à un cas particulier. (…) Nous savons aujourd’hui que ces derniers (les systèmes non-chaotiques), qui dominèrent si longtemps l’imagination des physiciens, forment en fait une classe très particulière. (…) C’est en 1892, avec la découverte d’un théorème fondamental par Poincaré ( la loi des trois corps), que se brisa l’image homogène du comportement dynamique : la plupart des systèmes dynamiques, à commencer par le simple système « à trois corps » ne sont pas intégrables.

Comment comprendre cet énoncé ? Depuis les travaux de Hamilton, on sait qu’un même système dynamique peut être représenté de différentes manières équivalentes par une transformation dite canonique (ou unitaire) (…) L’hamiltonien du système est la grandeur qui détermine son évolution temporelle.

Parmi toutes les transformations unitaires, il en existe une qui permet d’aboutir à une représentation privilégiée du système. C’est celle qui fait de l’énergie, c’est-à-dire de l’hamiltonien, une fonction des seuls moments, et non plus des positions. Dans une telle représentation, les mouvements des différentes particules du système sont décrits comme s’ils ne dépendaient plus des positions relatives des particules, c’est-à-dire comme si elles n’étaient plus en interaction. (…) Les mouvements possibles de tels systèmes ont donc la simplicité des mouvements libres. (…)

Or, en 1892, Poincaré montra qu’en général il est impossible de définir la transformation unitaire qui ferait des « actions » des invariants du système. La plupart des systèmes dynamiques n’admettent pas d’invariants en dehors de l’énergie et de la quantité de mouvement, et dès lors ne sont pas intégrables.

La raison de l’impossibilité de définir les invariants du mouvement qui correspondent à la représentation d’un système dynamique intégrable tient à un mécanisme de résonance. (…) Le mécanisme de résonance peut être caractérisé comme un transfert d’énergie entre deux mouvements périodiques couplés dont les fréquences sont entre elles dans un rapport simple.

Ce sont ces phénomènes de résonance – mais, cette fois, entre les différents degrés de liberté qui caractérisent un même système dynamique – qui empêchent que ce système soit mis sous une forme intégrable. La résonance la plus simple entre les fréquences se produit quand ces fréquences sont égales, mais elle se produit aussi à chaque fois que les fréquences sont commensurables, c’est-à-dire chaque fois qu’elles ont entre elles un rapport rationnel. Le problème se complique du fait que de manière générale les fréquences ne sont pas constantes. (…) Ce qui fait que, dans l’espace des phases d’un système dynamique, il y aura des points caractérisés par une résonance, alors que d’autres ne le seront pas. L’existence des points de résonance interdit en général la représentation en termes de variables cycliques, c’est-à-dire une décomposition du mouvement en mouvements périodiques indépendants.

Les points de résonance, c’est-à-dire les points auxquels les fréquences ont entre elles un rapport rationnel, sont rares, comme sont rares les nombres rationnels par rapport aux nombres irrationnels. Dès lors, presque partout dans l’espace des phases, nous aurons des comportements périodiques de type habituel. Néanmoins, les points de résonance existent dans tout le volume fini de l’espace des phases. D’où le caractère effroyablement compliqué de l’image des systèmes dynamiques telle qu’elle nous a été révélée par la dynamique moderne initiée par Poincaré et poursuivie par les travaux de Kolmogoroff, Arnold et Moser.

Si les systèmes dynamiques étaient intégrables, la dynamique ne pourrait nous livrer qu’une image statique du monde, image dont le mouvement du pendule ou de la planète sur sa trajectoire képlérienne constituerait le prototype. Cependant l’existence des résonances dans les systèmes dynamiques à plus de deux corps ne suffit pas pour transformer cette image et la rendre cohérente avec les processus évolutifs étudiés précédemment. Lorsque le volume reste petit, ce sont toujours les comportements périodiques qui dominent. (…)

Cependant, pour les grands systèmes, la situation s’inverse. Les résonances s’accumulent dans l’espace des phases, elles se produisent désormais non plus en tout point rationnel, mais en tout point réel. (…) Dès lors, les comportements non périodiques dominent, comme c’est le cas dans les systèmes chaotiques. (…)

Dans le cas d’un système de sphères dures en collision, Sinaï a pu démontrer l’identité entre comportement cinétique et chaotique, et définir la relation entre une grandeur cinétique comme le temps de relaxation (temps moyen entre deux collisions) et le temps de Lyapounov qui caractérise l’horizon temporel des systèmes chaotiques. (…)

Or, l’atome en interaction avec son champ constitue un « grand système quantique » auquel, nous l’avons démontré, le théorème de Poincaré peut être étendu. (…) La « catastrophe » de Poincaré se répète dans ce cas : contrairement à ce que présupposait la représentation quantique usuelle, les systèmes caractérisés par l’existence de telles résonances ne peuvent être décrits en termes de superposition de fonctions propres de l’opérateur hamiltonien, c’est-à-dire d’invariants du mouvement. Les systèmes quantiques caractérisés par des temps de vie moyens, ou par des comportements correspondants à des « collisions », constituent donc la forme quantique des systèmes dynamiques au comportement chaotique (…)

L’abandon du modèle des systèmes intégrables a des conséquences aussi radicales en mécanique quantique qu’en mécanique classique. Dans ce dernier cas, il impliquait l’abandon de la notion de point et de loi d’évolution réversible qui lui correspond. Dans le second, il implique l’abandon de la fonction d’onde et de son évolution réversible dans l’espace de Hilbert. Dans les deux cas, cet abandon a la même signification : il nous permet de déchiffrer le message de l’entropie. (…)

La collision, transfert de quantité de mouvement et d’énergie cinétique entre deux particules, constitue, du point de vue dynamique, un exemple de résonance. Or, c’est l’existence des points de résonance qui, on le sait depuis Poincaré, empêche de définir la plupart des systèmes dynamiques comme intégrables. La théorie cinétique, qui correspond au cas d’un grand système dynamique ayant des points de résonance « presque partout » dans l’espace des phases , marque donc la transformation de la notion de résonance : celle-ci cesse d’être un obstacle à la description en termes de trajectoires déterministes et prédictibles, pour devenir un nouveau principe de description, intrinsèquement irréversible et probabiliste.

C’est cette notion de résonance que nous avons retrouvée au cœur de la mécanique quantique, puisque c’est elle qu’utilisa Dirac pour expliquer les événements qui ouvrent un accès expérimental à l’atome, l’émission et l’absorption de photons d’énergie spécifique, dont le spectre constitue la véritable signature de chaque type d’atome. (…) Le temps de vie, qui caractérise de manière intrinsèque un niveau excité, dépend, dans le formalisme actuel de la mécanique quantique, d’une approximation et perd son sens si le calcul est poussé plus loin. Dès lors, la mécanique quantique a dû reconnaître l’événement sans pouvoir lui donner de sens objectif. C’est pourquoi elle a pu paraître mettre en question la réalité même du monde observable qu’elle devait rendre intelligible. (…)

Pour expliquer les transitions électroniques spontanées qui confèrent à tout état excité un temps de vie fini, Dirac avait dû faire l’hypothèse d’un champ induit par l’atome et entrant en résonance avec lui. Le système fini que représente l’atome isolé n’est donc qu’une abstraction. L’atome en interaction avec son champ est, lui, un « grand système quantique », et c’est à son niveau que se produit la « catastrophe de Poincaré ».

L’atome en interaction avec le champ qu’il induit ne constitue pas, en effet, un système intégrable et ne peut donc pas plus être représenté par l’évolution de fonction d’onde qu’un système classique caractérisé par des points de résonance ne peut être caractérisé par une trajectoire. C’est là la faille que recélait l’édifice impressionnant de la mécanique quantique. (…) Il est significatif que, partout, nous ayons rencontré la notion de « brisement de symétrie ». Cette notion implique une référence apparemment indépassable à la symétrie affirmée par les lois fondamentales qui constituent l’héritage de la physique. Et, en effet, dans un premier temps, ce sont ces lois qui ont guidé notre recherche. (…) La description à symétrie temporelle brisée permet de comprendre la symétrie elle-même comme relative à la particularité des objets autrefois privilégiés par la physique, c’est-à-dire de situer leur particularité au sein d’une théorie plus générale. »

Extrait de « Le temps et l’éternité » d’Ilya Prigogine et Isabelle StengerS

Le terme d’auto-organisation désigne l’émergence spontanée et dynamique d’une structure spatiale, d’un rythme ou d’une structure spatiotemporelle (se développant dans l’espace et le temps) sous l’effet conjoint d’un apport extérieur d’énergie et des interactions à l’oeuvre entre les éléments du système considéré.

De nombreux exemples biologiques répondent à cette définition. Le plus

emblématique est l’établissement du fuseau mitotique, structure transitoire qui réalise la ségrégation des chromosomes lors de la division cellulaire. Il a été montré que ce fuseau, ancré sur les parois de la cellule-mère, est un assemblage

dynamique de filaments, les microtubules, et de moteurs moléculaires (protéines

capables de se mouvoir et d’exercer des forces sur ces filaments). Les exemples

abondent aussi aux échelles supérieures : développement de colonies de

bactéries, variation périodique des populations dans un système prédateur-proie,

déplacement cohérent d’un banc de poissons, fourmilières. La notion n’est pas

spécifique au vivant : elle s’applique à la synchronisation d’oscillateurs

couplés, aux ondes observées dans certains systèmes chimiques alimentés en

continu, à l’apparition de motifs périodiques dans un liquide chauffé par le

dessous (cellules de convection), à la formation des dunes, des rivages, ou même

des galaxies.

Genèse de la notion d’auto-organisation

Cette notion est apparue au milieu du XXčme siècle, à la croisée des

mathématiques et de l’informatique, avec les travaux de J. Von Neumann sur les

automates cellulaires (modèles numériques discrets où l’état d’une cellule

évolue en fonction de l’état des voisines), et ceux de N. Wiener, fondant la

cybernétique (étude en parallèle de l’organisation, des mécanismes de contrôle

et de la communication dans les systèmes vivants et artificiels). Suivirent un

article fondateur d’A. Turing (1952) sur la morphogenèse (conception de modèles

où le couplage de réactions chimiques et de la diffusion des réactifs produit

des motifs en bandes) et les travaux d’I.Prigogine sur les structures

dissipatives (structures stationnaires hors d’équilibre où la dissipation

d’énergie entretient une organisation locale). Toutes ces études soulignèrent

l’importance des rétroactions, des non linéarités et du caractère ouvert et hors

d’équilibre des systèmes pour qu’il y apparaisse des formes stables et

reproductibles sans plan d’ensemble ni prescription extérieure. L’essentiel

était dit. Les ouvrages ultérieurs d’H. Von Foerster (1962), d’H. Haken (1977)

et de H. Atlan (1979) achevèrent d’établir et de populariser la notion d’auto

organisation. Les recherches portent aujourd’hui sur sa mise en évidence

expérimentale et sur l’élaboration de modèles opératoires, dans différents

domaines allant de la biologie à la linguistique, en passant par la physique et

les sciences sociales.

Les mécanismes de l’auto-organisation

Le préfixe "auto" souligne qu’il peut apparaître des phénomènes collectifs

robustes dans un ensemble d’éléments en interaction, sans qu’il y ait besoin ni

d’un chef d’orchestre, ni d’une préparation initiale inhomogène, ni de

conditions extérieures biaisant les interactions ou la dynamique individuelle.

Le terme central d’"organisation" suggère une apparition d’ordre et renvoie

aux notions d’entropie et d’information. Par exemple, une structure spatiale va

émerger d’un mélange homogène de composants. En termes techniques, on parle

d’une diminution (locale) de l’entropie. Il n’y a en cela nulle violation du

second principe de la thermodynamique puisque le système est ouvert : la

diminution d’entropie se fait aux dépens d’une consommation d’énergie. Une

partie de l’énergie absorbée par les organismes vivants sert ainsi à maintenir

leur organisation dynamique. Les structures auto-organisées sont hors

d’équilibre, car parcourues de flux de matière et d’énergie. Elles

s’évanouissent si on coupe les flux entrants : il est par exemple impossible de

figer et d’isoler un fuseau mitotique. Ces structures nous apparaissent

stationnaires si les flux entrants compensent les flux sortants. Pour ętre non

triviales, elles doivent découler de compétitions entre des tendances

contradictoires, par exemple une amplification locale (instabilité)

contrebalancée par un mécanisme d’inhibition plus global. Elles manifestent une

brisure de la symétrie présente initialement, typiquement amorcée par une

fluctuation, amplifiée par les non linéarités et stabilisée par un mécanisme de

rétroaction ; cette brisure de symétrie se traduit dans l’apparition de formes ou

de rythmes. Les interactions doivent donc être non linéaires mais elles peuvent

être ŕ courte portée (i.e. entre éléments voisins) et présenter une composante

aléatoire. Du fait de ces principes communs ŕ tous les phénomènes auto

organisés, des modèles trčs similaires se rencontrent dans des domaines trčs

différents et à des échelles trčs différentes (dynamique des populations et

réactions chimiques, par exemple).

Une notion parfois confondue avec l’auto-organisation , mais en réalité plus

faible, est la relaxation vers un état d’équilibre : lorsque l’énergie des

différents états du système (par exemple les différentes conformations d’une

protéine) dessine un paysage complexe, le système peut spontanément évoluer vers

une situation plus ordonnée, si celle-ci est assez favorable énergétiquement

pour compenser le coût entropique de l’ordre (cela correspond pour la protéine ŕ

se replier dans une structure bien déterminée). En autorisant le franchissement

de barrières énergétiques, le bruit permet une plus large exploration des états

possibles, et conduit ŕ des états plus ordonnés, ce qu’on fait lorsqu’on secoue

une boîte remplie de billes pour les tasser ou dans la technique métallurgique

du recuit.

Enjeux et prolongements de la notion d’auto-organisation

Une propriété des structures auto-organisées est d’être très sensibles aux

variations des paramètres contrôlant les interactions ; jointe à la sélection

naturelle, elle donne une grande capacité d’adaptation. Plus généralement,

lorsque les propriétés globales rétroagissent sur les propriétés des éléments,

on peut observer une stabilisation spontanée du système dans un état critique

(présentant des fluctuations à toutes les échelles d’espace et de temps) : on

parle de criticalité auto-organisée.

En biologie, des mécanismes d’auto-organisation semblent impliqués dans

l’homéostasie, l’établissement de la polarisation cellulaire, les réseaux

métaboliques, la différenciation cellulaire et le développement ; la notion

d’auto-organisation doit ainsi être coordonnée ŕ celles de signal et de

programme génétique, également invoquées pour expliquer ces phénomènes. D’autres

applications sont les mouvements de foule, l’évolution des systèmes de villes,

l’adaptation des écosystèmes, les structures cognitives où l’auto-organisation

rejoint la notion d’apprentissage.

L’auto-organisation a ainsi apporté l’idée que des formes stables et

statistiquement reproductibles peuvent découler d’un équilibre dynamique,

mettant en jeu des règles locales et stochastiques. Il s’agit d’un phénomène

essentiellement collectif : les propriétés globales ne peuvent se réduire à

celles d’un ou plusieurs éléments isolés ; on rejoint là les notions (encore

inachevées) d’émergence et de complexité.

Simon Diner

FORMES et AUTO-ORGANISATION

L’art est essentiellement la création de formes et toute perception de formes peut constituer le départ d’une expérience artistique. Mais la reconnaissance des formes est une opération délicate où interviennent des facteurs objectifs, liés aux facteurs généraux de la perception et de la connaissance, et des facteurs contextuels liés à la culture (conditions socio-historiques, choix philosophiques, représentation du monde). Il en est de même pour les caractères artistiques et esthétiques. Si l’art se définit de manière très générale comme une manifestation d’expression et d’expressivité, assumant un flirt incessant entre art et sémiotique, le rôle essentiel des formes apparaît précisément dans leur fonction de support d’identité et d’expression, et donc de communication .

Ce jeu complexe des formes dans la détermination de l’art explique l’assimilation fréquente des concepts d’art et de forme, comme cela apparaît clairement dans la dénomination d’ « Univers des formes » utilisée dans la dénomination d’une histoire universelle des arts publiée dans la seconde moitié du XX ème siècle. Ou bien encore dans l’écriture par un historien d’art comme Henri Focillon d’un livre intitulé « La vie des formes ». Comme l’a si bien dit le philosophe A.N. Whitehead : « Art is the imposing of a pattern on experience, and our aesthetic enjoyment is recognition of the pattern” ( Dialogues. June 1943).

La notion de forme est si générale et va tellement au delà d’une simple caractérisation d’objets matériels, mais s’étend à la langue, à la musique ou au comportement, que la tentation a été fréquente de lui donner une existence autonome. C’est ainsi que Platon envisageait l’existence de formes séparées de la matière (les fameuses idées), alors qu’Aristote ne l’admettait pas dans sa doctrine hylémorphique. Un débat qui n’en finit plus et qui se trouve au cœur des différentes conceptions de la forme. Ce qui n’est pas sans influence sur les pratiques artistiques, témoin l’art abstrait qui cherche à s’emparer de la forme pure. Les « purs rapports » évoqués par Mondrian.

La forme désigne cet aspect de l’être qui en marque l’identité en lui assurant spécificité et stabilité. Exister, c’est exister en tant qu’un et le même. Il y a là l’expression d’une totalité qui exprime une différentiation spécifique et une résistance au changement. C’est à travers la définition de la forme et sa reconnaissance que se produit la connaissance de l’être. La forme est une modalité d’existence de l’être, ce qui fait qu’une chose est ce qu’elle est. Concept que la scholastique latine désignait par quiddité, tout en introduisant le mot forma, pour rendre les mots grecs idea, eidos, morphe et ritmos. A ce stade linguistique il faudrait adjoindre au mot forme, les termes de figure et de structure (structuralisme), pour équilibrer la diversité anglaise de form, shape et pattern.

La philosophie grecque a montré que la réflexion sur la forme est à la base de deux conceptions du monde.

Une conception où les formes sont données à priori, formes abstraites et transcendantes auxquelles la nature sensible se conforme. C’est la théorie platonicienne des Idées : une idée est ce qui est toujours identique à soi même (stabilité), ce qui est l’unité d’une multiplicité et ce qui est pris comme modèle pour faire une chose ou accomplir une action. Une conception où la diversité de la nature proviendrait de l’assemblage de formes simples données par avance. Une conception atomistique* du monde. La vision atomique et moléculaire du monde ne procède pas autrement aujourd’hui. Elle renforce des positions très répandues en psychologie où l’on pense que la perception a pour objets immédiats des formes élémentaires (Théorie de la Gestalt). Vision commune à celle des catégories de l’entendement de Kant ou à la conception des achétypes inconscients de Jung. La conception atomistique domine jusqu’à présent le champ de la biologie moléculaire.

Une autre conception pense que la forme est en puissance dans la matière et s’actualise par la matière sans que l’on puisse séparer la matière de la forme. La forme est un tout qui actualise la matière en s’actualisant. C’est là l’esprit de la doctrine hylémorphique d’Aristote, qui donne naissance à une conception où la matière et le mouvement se conjuguent pour créer la forme. La forme est alors un Tout qui transcende la matière et ne résulte pas de la simple addition des propriétés de ses parties. Une propriété émergente.

Une transcendance qui hante l’histoire de la philosophie naturelle dans l’esprit d’un néo-aristotélisme. Leibniz, Goethe, Schelling, Husserl, D’Arcy Thompson, Waddington, la Gestalt Theorie, Türing, Thom et la Théorie des catastrophes, en sont les héros.

Cette conception a connu au XXème siècle des développements scientifiques majeurs dans le cadre de la théorie des systèmes dynamiques, qui a mis en évidence des mécanismes d’apparition de formes. Ces mécanismes exploitent la propriété mathématique (physique) de nonlinéarité, à l’origine du phénomène de transcendance de la forme. Ils exploitent souvent le phénomène de brisure de symétrie et peuvent se manifester dans des régimes dynamiques loin de l’équilibre (structures dissipatives). Grâce à l’ordinateur, on a pu créer des formes nouvelles, comme les fractals, qui permettent de mieux comprendre les formes reconnues dans la nature.

Du point de vue contemporain, la forme est un compromis entre l’information (originalité, diversité, surprise) et l’intelligibilité (calculabilité, discursivité, réductibilité à un discours). Trop d’information tue la forme. Un phénomène stochastique (chaotique) n’a pas de forme, car il est un trop plein d’information non réductible à un algorithme (complexité algorithmique). Cette complexité le rend rebelle à toute prévisibilité au moyen d’un discours.

Le Vide, quel qu’il soit, est une absence de forme, à la fois par absence d’information et aussi sans doute par excès. Loin d’être Rien, il est au contraire le Vide par surdétermination au delà du raisonnable.

En fait la forme n’est pas une manifestation en soi (une substance pour ainsi dire), même si elle donne à la matière son caractère de substance selon l’hylémorphisme aristotélicien. Toute réflexion sur l’absence de forme, comme réflexion essentielle sur les conditions de l’apparition de la forme, souligne le caractère contextuel et relationnel de la forme. La forme ne prend sens que vis à vis d’autres formes ou comparée à la non forme. La non forme est la condition d’existence de la forme. On retrouve là aussi en écho la distinction entre forme accidentelle et forme substantielle, que l’on pourrait dénommer forme normale, car elle oppose le normal au pathologique.

« Tout vient du fond et y retourne » disait Joan Miro. C’est que la forme ne prend corps que si elle traduit une différence. Nous ne percevons que des différences, comme l’a si bien exprimé Gregory Bateson dans sa conférence « Form, substance and difference » (1970).

Déjà au début du siècle Ferdinand de Saussure, créateur de la linguistique, et Ernest Cassirer, l’auteur des « Formes Symboliques », critiquaient le substantialisme et défendaient la priorité des notions fonctionnelles ( qui ne sont pas dérivées des objets mais servent à former le notion d’objet). Ainsi Ferdinand de Saussure écrit dans le texte inédit « De l’essence double du langage » :

« Il y a dans la langue ni signes ni significations, mais des différences de signes et des différences de significations lesquelles 1° n’existent absolument les unes que par les autres (dans les deux sens) et sont donc inséparables et solidaires ; mais 2° n’arrivent jamais à se correspondre directement. »

Le concept de forme ne prend ainsi son sens véritable que dans le cadre de la théorie de l’information, où selon le mot de Bateson, l’information est une différence qui fait la différence.

Toutes les expressions artistiques ont recours à la construction de fonds pour mieux affirmer le forme par contraste et la problématique figure-fond mise à l’honneur par la psychologie gestaltiste est récurrente dans bien des domaines.

Le vide et le fond sont un même combat pour l’expressivité de la forme.

Il est clair que toute phénoménologie de la forme doit tenir compte des mécanismes de perception de la forme (Cf. Perception des formes).

Une des plus grande découverte du XX ème siècle est de montrer la possibilité de création spontanée de formes au sein d’un système en évolution. C’est l’auto-organisation.

On parle d’auto-organisation lorsqu’un système abandonné à lui même, hormis des interactions peu spécifiques avec l’environnement, tend à devenir plus organisé. C’est là une propriété inattendue et contre intuitive, si l’on croît qu’un système abandonné à lui même tend à se désorganiser, et que l’ordre provient d’une intervention extérieure, une intelligence humaine ou divine. Les doctrines de l’auto-organisation reposent sur l’exploitation des propriétés des systèmes non linéaires, tout en utilisant souvent des idées assez vagues sur l’organisation, la forme ou l’ordre.

Le terme d’auto-organisation semble avoir été introduit par le cybernéticien W. Ross Ashby, mais ne s’est répandu que dans les année 70 lors de l’explosion de l’étude des systèmes dynamiques non linéaires initiée par les mathématiciens soviétiques.

En fait la théorie des auto–oscillations selon Andronov (1928) constitue un paradigme fondateur pour l’auto-organisation, dans le cas particulier des formes périodiques. Les auto-oscillateurs sont responsables de la plupart des phénomènes temporels périodiques observés ou créés. Un émetteur radio, une horloge ou un laser sont des systèmes auto-oscillants typiques, comme le sont des systèmes chimiques (Réaction de Belousov-Zhabotinsky) ou des systèmes biologiques comme le cœur ou les rythmes de la production hormonale. Les instruments de musique à corde frottée ou à vent sont des auto-oscillateurs, et les sons qu’ils produisent sont totalement structurés par les propriétés physiques de tels systèmes. Les auto-oscillateurs sont en fait comme la plupart des systèmes auto-organisés des systèmes non-linéaires ouverts avec entrée d’énergie (ou de matière ) et dissipation d’énergie (ou de matière ).

On peut considérer l’auto-organisation comme une adaptation à des contraintes extérieures peu spécifiques et désordonnées (aléatoires même), fondée sur les propriétés intrinsèques du système. Cette adaptation munit la forme de propriétés de stabilité particulières. La forme constitue une stabilité des choses face à la contingence du réel. La production de formes par la morphogenèse biologique est le signe indubitable de la stabilité des organismes vivants. Mais il ne s’agit sans doute pas de n’importe quelle stabilité. Aux yeux du grand mathématicien René Thom, il s’agit de la stabilité structurelle. Dans son livre historique « Stabilité structurelle et morphogenèse » (1972), à la page 31, il livre le fond de sa pensée :

« La notion de stabilité structurelle est à mes yeux, une notion clé dans l’interprétation des phénomènes, de quelque discipline que ce soit (sauf peut être en physique quantique)...... observons seulement que les formes subjectivement identifiables, les formes pourvues d’une dénomination, représentées dans le langage par un substantif, sont nécessairement des formes structurellement stables. »

De fait le mécanisme général d’apparition de formes par brisure spontanée de symétrie correspond au rétablissement d’une stabilité structurelle, là où la symétrie en empêchait la présence.

La brisure de symétrie a été pour la première fois reconnue comme fondamentale pour l’apparition des formes par le génie mathématique qu’était Alan Turing en 1952. Toute l’activité de Turing avait jusque là été totalement consacrée aux ordinateurs et à la logique, depuis la fameuse machine de Turing, modèle idéal de l’ordinateur jusqu’à un des premiers calculateurs électroniques Colossus. Mais Turing s’intéressait à ce qu’il considérait comme le problème fondamental de la biologie : rendre compte des figures et des formes. Vu son passé et l’esprit de l’époque dominé par la génétique, on aurait pu penser qu’il aurait essayé de décrire l’apparition de la forme comme le résultat d’un calcul programmé dans les gênes. Mais précisément c’est ce qu’il ne voulait pas, cherchant à éliminer un mécanisme d’apparition des formes biologiques lié à un dessein extérieur génétique ou divin.

Fortement influencé par d’Arcy Thompson, il crée une théorie de l’apparition de formes par instabilité des solutions d’équations de réaction-diffusion. Il s’appuie pour cela sur les propriétés de bifurcation des solutions d’équations différentielles, qui accompagne la variation d’un paramètre du système avec changement qualitatif profond lorsque ce paramètre passe par une valeur critique. Un état préalablement stable devient instable. Une distribution homogène de matière créée par une réaction chimique se mue en une distribution exhibant une forme, c’est à dire que l’on assiste à une brisure de symétrie. Cette brisure provient de l’amplification soudaine des petites irrégularités (fluctuations) réellement présentes dans la situation symétrique.

Ce mécanisme d’apparition de formes par brisure de symétrie dans des équations non-linéaires de réaction-diffusion a mis en place le premier paradigme important de création dynamique de la forme. Il a été largement confirmé par la théorie et l’expérience.

L’effervescence scientifique provoquée par le développement de la théorie des systèmes dynamiques et de la physique non linéaire, a donné naissance à diverses écoles ou courants de pensée, regroupés autour de certaines personnalités. Le rôle de ces écoles et de leurs inspirateurs n’a peut être pas été tant dans de véritables découvertes que dans la médiatisation de toutes ces nouvelles idées. Une médiatisation accompagnée par la création de vocables, véritables slogans servant d’enseigne à ces écoles, et créant souvent autour de leurs doctrines un halo qui n’aide pas à juger de la diversité des approches.

L’Ecole de Bruxelles doit sa renommée à l’activité et au talent de son fondateur, I. Prigogine, prix Nobel de chimie. C’est une école de thermodynamique, regroupée autour du sigle : « structures dissipatives ». Elle étudie la formation de structures organisées dans les systèmes hors de l’équilibre. Elle se fonde sur des principes de minimum de production d’entropie et utilise la production en excès de l’entropie comme un moyen pour rechercher l’apparition d’une instabilité, génératrice de formes. Malgré de très nombreux travaux théoriques, en particulier sur des modèles de réactions chimiques, il ne semble pas que cette école ait véritablement fondé une science de l’apparition des formes.

L’Ecole de Francfort, dirigée par H. Haken, a adopté comme sigle le terme « Synergétique ». Théoricien du laser, Haken a cherché à généraliser la théorie des phénomènes exigeant la coopération entre de nombreux acteurs. Tout en encourageant de nombreux travaux dans ce domaine et en multipliant les colloques, Haken, rival de Prigogine, n’a pas formulé une véritable doctrine de l’origine des formes.

Alors que Prigogine et Haken sont des physiciens, ce sont des biologistes H. Maturana et F. Varela, qui ont tenté d’élaborer une doctrine générale des formes, valable pour les systèmes biologiques et les systèmes cognitifs. Leur concept central est celui « d’autopoièse » ou de machine autopoiètique, réalisé par un réseau de processus entrelacés. C’est une approche qui se situe dans une certaine tradition cybernétique qui considère à sa façon les phénomènes d’auto-organisation.

La théorie des catastrophes du mathématicien René Thom a acquit une grande célébrité. La personnalité de son auteur, médaille Field (le Nobel des maths ) de mathématiques, tout autant que les mystères mathématiques dont elle s’entoure, expliquent ce succès philosophique et médiatique.

Les catastrophes sont des variations discontinues apparaissant comme des réponses soudaines d’un système à une variation continue des conditions extérieures.

La théorie des catastrophes est née de l’union de la théorie des singularités et de la théorie des bifurcations des systèmes dynamiques (Poincaré, Andronov). Son objet n’est pas tout à fait défini. Thom la considère comme un état d’esprit et non comme une théorie au sens ordinaire. C’est un programme mathématique, dont l’application varie d’un spécialiste à l’autre, mais avec pour traits généraux une attention particulière pour le typique, la stabilité structurelle et le point de vue géométrique. La théorie classe les discontinuité du mouvement en terme d’un petit nombre de formes archétypales que Thom nomme les catastrophes élémentaires.

La théorie des catastrophes a été appliquée à l’optique géométrique et à l’optique physique, à l’hydrodynamique, à la stabilité des navires, à l’étude des battements cardiaques, à l’embryologie, à la sociologie, à la linguistique, à la psychologie expérimentale, à l’économie, à la géologie, à la théorie des particules élémentaires, à la modélisation de l’activité cérébrale et psychique.....

Elle peut sembler une science carrefour et constituer une vision du monde, c’est ce qui fait son aura.

La dernière grande idéologie de la forme est apparue à l’époque informatique et doit son développement à l’utilisation massive des ordinateurs. Elle est développée par un mathématicien informaticien, Stephen Wolfram, l’auteur de l’ensemble de programmes de calculs mathématiques connu sous le nom de « Mathematica ».

L’étude scientifique de la nature et de l’homme est envisagée à l’aide de programmes de calcul plutôt qu’à l’aide d’équations mathématiques (A new kind of science). Les phénomènes du monde sont considérés comme résultant de l’exécution de myriades de programmes simples. Le programme simple par excellence étant l’automate cellulaire. L’immense richesse des formes obtenues à l’aide d’automates cellulaires illustre et conforte ce point de vue. L’automate cellulaire devient un outil privilégié de création des formes, ce dont témoignent les travaux d’art numérique ( comme ceux de Bernard Caillaud ).

P. BALL. The self-made tapestry. Pattern formation in nature. Oxford University Press. 2001. Essentiel.

J. PETITOT. Forme. Encyclopaedia Universalis. Paris. 1989.

Y. BOULIGAND, ed. La morphogénèse : de la biologie aux mathématiques. Maloine. Paris. 1980.

Quelques ouvrages marquent l’histoire de la forme au XX ème siècle :

S. LEDUC. La biologie synthétique. A. Poinat. Paris. 1912 ( disponible en ligne sur

http://www.peiresc.org/bs01.htm )

D’ARCY WENTWORTH THOMSON. On growth and form. 1917

Edition abrégée : Cambridge University Press. 1961.

A.M. TURING. The chemical basis of morphogenesis. Phil. Trans. R. Soc. London B237, 37-72, 1952. (reproduit dans collected works of A.M. Türing. Morphogenesis, ed. P.T. Saunders. North Holland. 1992.).

R. THOM. Stabilité structurelle et morphogénèse. Essai d’une théorie générale des modèles. Interéditions. Paris. 1972.

B. MANDELBROT. The fractal geometry of nature. Freeman. 1982.

H.O. PEITGEN and P.H. RICHTER. The beauty of fractals. Images of complex dynamical systems. Springer. 1988. Le départ de la mode des fractals.

H. MEINHARDT. The algorithmic beauty of sea shells. Springer.1995.Lle triomphe du modèle de Türing de réaction-diffusion.

S. WOLFRAM. A new kind of science. Wolfram Media. 2002. L’automate cellulaire roi.

La physique non-linéaire et l’auto-organisation sont le sujet d’innombrables ouvrages ou publications, où auto- organisation et chaos déterministe se côtoient souvent.

Le livre de G.Nicolis, Introduction to nonlinear science, Cambridge University Press, 1994, constitue une des meilleures introduction générale.

On trouvera de nombreuses informations dans les chroniques de Cosma Shalizi :

http://cscs.umich.edu/~crshalizi/notebooks

Cf. en particulier : self-organization, pattern formation, dissipative structures, emergent properties, cellular automata...

Consulter la FAQ Self-organizing systems (SOS) :

http://www.calresco.org/sos/sosfaq.htm

G. NICOLIS and I. PRIGOGINE. Self-organization in non equilibrium systems. From dissipative structures to order through fluctuations. Wiley. 1977.

A.T. WINFREE. The geometry of biological time. Springer. 1980.

V.S. ZYKOV. Modelling of wave processes in excitable media. Naouka. Moscou. 1984.(en russe) [ traduction anglaise Manchester University Press. 1988.]

A. BABLOYANTZ. Molecules, dynamics and life. An introduction to self-organization of matter. Wiley. 1986.

A.T. WINFREE. When time breaks down : The three dimensional

dynamics of electrochemical waves and cardiac arythmies. Princeton University Press. 1987.

L. GLASS and M.C. MACKEY. From clocks to chaos : The rythms of life. Princeton University Press. 1988.

G. NICOLIS and I. PRIGOGINE. Exploring complexity. Freeman. 1989.

G. NICOLIS. Physics of far from equilibrium systems and self-organization. Dans, P. Davies,ed. The new physics. Cambridge University Press.1989.

P. GRINDROD. Patterns and waves. The theory and applications of reaction-diffusion equations. Oxford University Press.1991.

E. MERON. Pattern formation in excitable media. Physics Reports. 218, 1-66, 1992.

J.S. KIRKALDY. Spontaneous evolution of spatio-temporal patterns in materials. Rep. Prog. Phys. 55, 723-795, 1992.

L.G. HARRISON. Kinetic theory of living pattern. Cambridge University Press.1993.

S. KAUFFMAN. The origin of order. Self-organization and selection in evolution. Oxford university Press.1993.

A. GOLDBETER. Biochemical oscillations and cellular rythms. The molecular bases of periodic and chaotic behaviour. Cambridge university Press. 1996.

C. SHALIZI. Causal architecture, complexity and self-organisation in time series and cellular automata. Thesis. 2001.

http://bactra.org/thesis

La morphogenèse biologique donne lieu à des publications spécifiques.

A.R. PEACOCKE. An introduction to the physical chemistry of biological organization. Oxford university Press. 1983

J. MURRAY. Mathematical biology. Springer . 1989. (dernière édition augmentée en 2 volumes. 2002 ). Les taches du léopard......

Présentation de l’œuvre de Turing, en particulier sur la phyllotaxie :

http://www.swintors.net/jonathan/turing.htm

A. GIERER. Generation of biological patterns and form : Some physical, mathematical and logical aspects. Prog. Biophys. Mol. Biol. 37, 1-47, 1981.

H. MEINHARDT. Models of biological pattern formation. Academic Press.1982.

H. MEINHARDT. Pattern formation in biology : a comparison of models and experiments. Rep. Prog. Phys. 55, 797-849, 1992

P. PRUSINKIEWICZ and A. LINDENMAYER. The algorithmic beauty of plants. Springer. 1990.

P. PRUSINKIEWICZ, M. HAMMEL and R. MECH. Visual models of morphogenesis:a guided tour.

http://www.cpsc.ucalgary.ca/projects/bmv/vmm-deluxe/TitlePage.html

J.A. KAANDORP. Fractal modelling : Growth and form in biology. Springer. 1994.

J. MARZEC. A pragmatic approach to modeling morphogenesis. J. of Biological Systems. 7, 335-351, 1999.

J. MARZEC. Mathematical morphogenesis.

http://www.albany.edu/~cmarzec

E. BEN JACOB, I. COHEN and H. LEVINE. The cooperative self-organization of microorganisms. Adv. Phys. 49, 395-554, 2000.

S. CAMAZINE, J.L. DENEBOURG, A. FRANKS, J. SNEYD, G. THERAULAZ and E. BONABEAU. Self-organization in biological systems. Princeton University Press. 2001.

Structures auto-organisées dans les systèmes loin de l’équilibre, le film

Stuart Kauffman écrit dans « La complexité, vertiges et promesses » :

« J’ai volontairement écrit mon premier livre sur les origines de l’ordre (intitulé « Auto-organisation et sélection dans l’Evolution des espèces ») sans jamais définir l’auto-organisation. (...) J’étais beaucoup plus préoccupé de montrer des cas concrets d’auto-organisation. (...) L’autocatalyse est un cas concret d’auto-organisation. Lorsque vous augmentez la diversité moléculaire des espèces dans un système, la diversité des réactions qu’elle peut engendrer augmente plus rapidement que la diversité des espèces. (...) On peut démontrer mathématiquement qu’une transition de phase survient lorsque la diversité moléculaire augmente. Ce qui qualifie un phénomène émergent, c’est une propriété collective qui n’est présente dans aucune des molécules individuelles. Les lois qui gouvernent les systèmes émergents sont en relation avec les lois mathématiques des transition de phase survenant dans de tels systèmes, et plus généralement dans tout ce qui se passe à un niveau supérieur à celui des molécules individuelles. »

La reconnaissance de l’existence de multiples processus d’auto-organisation dans la nature, vivante et non vivante, est d’origine relativement récente. Autrefois, on en était restés à l’idée de la tendance naturelle au désordre. Se fondant sur le mélange des gaz, l’établissement d’une température et d’une pression moyennes, sur l’étude des machines thermiques et des moteurs, la thermodynamique appelait entropie cette "tendance au désordre maximum".

Aujourd’hui, nous reconnaissons la capacité spontanée de la nature à produire de l’ordre : formation d’une étoile, d’un nuage, d’un flocon de neige, d’un cristal. L’exemple le plus éclatant est celui de la vie. En permanence, des cellules se spécialisent, se distribuent des rôles, interagissent.

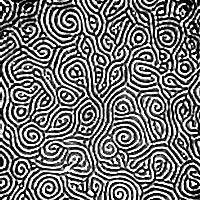

LA CONVECTION ET L’AUTO-ORGANISATION

Motifs convectifs auto-organisés se formant dans de l’eau très chaude

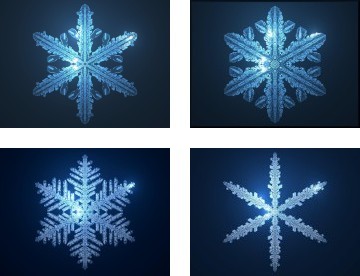

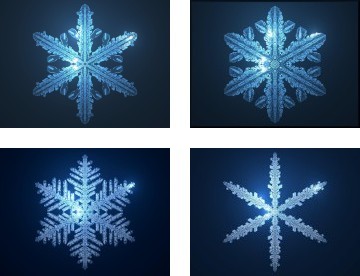

L’AUTO-ORGANISATION DU FLOCON DE NEIGE

Le flocon de neige est une structure complexe (une très grande variété de types de flocons) qui est produite par auto-organisation. Des procédures simples d’agrégation dendritique permettent de construire progressivement le flocon en fonction de la température, de la pression et de la densité. Il n’y a pas de modèle préétabli du résultat final qui se construit petit à petit en mêlant progression aléatoire et lois physique et géométrique d’agrégation. Il n’y pas deux flocons identiques. Chaque pas de construction est irréversible et est une bifurcation du schéma.

Formation de la neige et de la glace

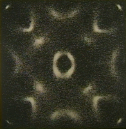

EXEMPLE DE STRUCTURE DISSIPATIVE AUTO-ORGANISÉE

Une plaque métallique est reliée à un générateur de fréquences sonores. Un sable très fin est disposé sur le dessus. Pour certaines fréquences bien précises, des structures géométriques apparaissent.

Transition de phase dans une croissance/diffusion auto-organisée

Un exemple de l’ordre issu du désordre : la matière

Maurice Jacob dans "Au coeur de la matière" :

"Au coeur de la matière et à l’échelle du cosmos

La nature est plus riche que notre imagination. On peut démonter les molécules en atomes. On peut arracher les électrons d’un atome et séparer les protons et les neutrons qui constituent son noyau. On découvre les différents niveaux de la matière qui mettent en jeu des constituants de plus en plus élémentaires. (...) La masse, cette propriété que l’on pensait intrinsèquement associée à un objet et qui résultait de l’addition des masses de ses constituants, une masse que l’on associait à chaque particule avant de considérer les forces auxquelles ellles pouvaient être soumises, cette masse devient un effet dynamique des actions auxquelles les constituants fondamentaux sont soumis. (...) Les particules élémentaires sont les quarks (qui forment notamment les protons et les neutrons) et les leptons (comme l’électron). (...) Les forces qui leur permettent d’interagir entre eux sont toutes du même type : elles prennent la forme particulière d’un échange de bosons. (...) L’un de ces bosons est le "grain de lumière", le photon. (...) Deux particules chargées s’attirent ou se repoussent en échangeant des photons. Au cours d’un choc, ou simplement accélérée, une particule chargée peut émettre un photon (...) dont la fréquence est proportionnelle à son énergie. (...) L’atome est formé d’un tout petit noyau entouré d’un "nuage" d’électrons. Le rayon du noyau est cent mille fois plus petit que celui de l’atome, mais il contient pratiquement toute la masse. l’atome est donc pratiquement vide mais son volume, extrêmement vaste par rapport à celui du noyau, est rempli par le mouvement incessant des électrons qui se concentrent sur des couches successives. Le noyau a une charge positive et les électrons ont uen charge négative. Ils sont tous attirés par le noyau mais tournoient à une distance respectable. L’atome est globalement neutre, la charge totale des électrons étant compensée par celle des protonsqui se trouvent dans son noyau. (....) En physique quantique, il faut renoncer à considérer une particule comme parfaitement localisable. (...) Ce flou quantique peut heurter l’intuition naturelle (...) ne peut-on envisager l’observation d’un électron pendant un temps très court durant lequel il ne pourrait parcourir qu’une petite partie de la distance associée à ce flou quantique ? C’est possible mais on ne peut plus distinguer dans ce cas l’électrons des multiples autres particules (paires d’électrons et de positrons fugitifs du vide) qui peuvent être librement émises et réabsorbées durant ce temps très court. (...) Le vide est animé par la création continuelle et la disparition rapide de paires électron-positron (le positron est l’antiparticule de l’électron). Ce sont des paires virtuelles (...) L’électron de charge négative va attirer les positrons de ces paires virtuelles en repoussant leurs électrons. En approchant de l’électron, le photon va se voir entouré d’un "nuage" de charge positive dû aux positrons virtuels attirés. Il aura l’impression que la charge de l’électron est plus faible que celle annoncée. (...) la masse des particules vient de la structure du vide qui s’est figé au début de l’évolution de l’Univers (...) La diversité de la matière sort de la structure du vide. (...) le vide bouillonne d’activité, il peut même exister sous plusieurs formes et manifester une structure. (...) Ce bouillonnement d’activité est de nature quantique."

Messages

1. L’auto-organisation ou l’ordre spontanément issu du désordre, 31 octobre 2018, 06:51, par Robert Paris

Il faut porter un regard critique sur ce qui est considéré ordinairement comme les caractéristiques de l’auto-organisation (dont l’essentiel reste la puissance du feed-back et de la récursivité) :

L’absence de contrôle centralisé (compétition)

C’est le plus absurde, au moins outrancier. Il serait plus raisonnable de parler d’une pluralité de centres de décision (ou de contrôle distribué) et de processus initiés par la base (bottom-up) mais on ne peut se passer complètement d’une régulation centralisée, au moins en dernier recours, indispensable conscience de soi politique. Il faut opposer la coopération, qui est le principe de l’autogestion, à cette compétition généralisée.

Processus dynamiques (évolution temporelle)

Il est effectivement important de raisonner dynamiquement et de se situer dans une évolution historique mais il ne peut y avoir de dynamique sans régulation qui l’équilibre afin de garder une indispensable stabilité et cohérence interne.

Fluctuations (exploration d’options multiples)

La nécessité de la souplesse ou de la flexibilité s’impose sans doute mais là encore, il y a une limite. Il faut pouvoir s’appuyer sur des fondations solides et une certaine coordination des actions. Surtout, il faut pouvoir se projeter dans l’avenir et tenir compte du long terme, pas seulement de la réalité immédiate.

Instabilité (renforcement positif)

L’instabilité aussi doit etre relative, et s’il est très utile de récompenser les performances, de favoriser les actions qui vont dans le bon sens par un feed-back positif, il ne faut pas trop s’emballer ni détruire toute solidarité interne au risque de tout désorganiser. La nécessité d’un feed-back négatif, d’une homéostasie qui amortit les fluctuations est absolument vital.

Brisure de symétrie (réduction des degrés de liberté)

Toute organisation implique des règles, des conventions, des mouvements collectifs, la canalisation des flux et la transmission de contraintes, leur intériorisation. L’autonomie d’un groupe est directement fonction du respect de ses contraintes internes. La perte de liberté doit bien sûr rester relative, limite de l’autonomie assurant la cohérence globale. On peut dire avec Michel Foucault que plus il y a de libertés, plus il y a de pouvoirs. C’est une nécessité dialectique. Cela ne veut pas dire qu’on ne devrait pas résister aux pouvoirs et les subir passivement sans rétroaction.

Equilibres multiples (variété des attracteurs)

On a vu que tout système complexe se caractérise effectivement par une multiplicité d’états stables et de stratégies possibles (équifinalité) mais le choix entre elles n’est pas obligatoirement aveugle et "auto-organisé".

Points critiques (transition de phase)

Il est sans aucun doute crucial de repérer les points de bifurcation entre différents régimes, de changements qualitatifs, de réorganisation globale, voire des points de non-retour. Cela justifie plutôt la prudence, la vigilance et la réactivité (principe de précaution), une certaine planification plutôt que le laisser-faire.

Ordre global (émergent des interactions locales)

L’existence de qualités globales distinctes des éléments le constituant fait partie intégrante de la définition d’un système. Ce n’est pas une raison, comme on l’a vu, pour prétendre que le comportement global émerge spontanément (inconsciemment) des interactions locales alors que, pour une grande part, ce comportement est le résultat d’interactions globales avec d’autres systèmes ou peut s’expliquer par une contrainte globale voire des finalités explicites.

Dissipation d’énergie

On sait effectivement que, la plupart du temps, organisation, structure, complexification peuvent résister à l’entropie grâce au flux d’énergie qui les traverse, équilibrant leur gain de stabilité par un coût entropique externe (le plus souvent d’origine solaire). C’est ce qu’on appelle les structures dissipatives. C’est un point important qu’il faut prendre en compte. Cependant des optimisations locales (niches écologiques) peuvent se traduire par une complexification correspondant à une optimisation de la dépense énergétique, sans coût énergétique supplémentaire. Les phénomènes biologiques ne sont pas assimilables à des structures dissipatives car ils s’opposent justement à la dissipation d’énergie.

Redondance (insensibilité aux dégâts subis)

La redondance de l’information est primordiale pour assurer l’autonomie, la plasticité et la solidité d’une organisation complexe adaptative, mais il y a là aussi une dialectique subtile entre redondance et variété pour assurer à la fois une diversité de réactions face aux atteintes extérieures et la stabilité de l’organisation.

Régénération (réparation et remplacement des pièces défectueuses)

C’est ce qui caractérise l’autopoièsis et ne se retrouve qu’assez rarement en dehors des organismes vivants dont c’est la spécificité. Les organisation peuvent changer leur matériel ou leur personnel mais leur régénération est le plus souvent catastrophique, suite à ce que Schumpeter appelait des "destructions créatives" qui ne relèvent donc pas du tout de l’auto-organisation. Ce qu’on appelle la résilience est une version atténuée de la capacité de se reconstruire après une épreuve désorganisatrice.

Adaptation (stabilité face aux variations externes)

On a vu que l’adaptation est toujours relative et qu’il ne faut pas être trop adapté à l’environnement immédiat pour durer à plus long terme. Il faut distinguer en effet l’adaptation aux petites variations ordinaires de la résistance à des catastrophes plus exceptionnelles ou des transformations importantes de l’environnement. L’adaptation ne relève pas toujours de l’auto-organisation mais peut être contrainte par l’environnement ou même planifiée d’avance.

Complexité (multiples paramètres)

La complexité d’un système implique effectivement l’existence de stratégies et paramètres multiples qui peuvent être coordonnés ou concurrents. Il faut donc éviter tout simplisme destructeur mais il n’y a là aucune nécessité d’auto-organisation puisque l’action simultanée en plusieurs points est beaucoup plus efficace lorsqu’elle est coordonnée et pilotée par un centre de décision.

Hiérarchies (multiples niveaux auto-organisés)

On a vu que la structure arborescente des systèmes complexes est indispensable pour en limiter la complexité. C’est une caractéristique des systèmes finalisés bien plus que de l’auto-organisation elle-même. L’autogestion de chaque niveau est souhaitable, il n’est pas sûr que l’auto-organisation soit pour autant le plus efficace aussi bien à chaque niveau que globalement. L’autonomie doit plutôt être organisée, mais il serait tout de même paradoxal d’identifier hiérarchies et auto-organisation. Les structures dissipatives par exemple ne sont pas hiérarchisées la plupart du temps et les fractales qui peuvent en tenir lieu ne sont pas auto-organisées non plus mais résultent d’une force extérieure à longue portée qui rencontre des résistances locales qui la fragmentent.

Jean Zin